很多人收到一条语音信息就被骗了。

刘倩突然收到一条来自多年不联系好友的微信消息,「最近在忙什么?」「要不要见一面?」

从打招呼、互相寒暄到吐槽近况,整个聊天过程自然而然。她感叹几年过去了,好友仍是语气可爱的「软萌妹子」,甚至记得她们曾在北京隆冬的某一天晚上在街头分食一份煎饼。

聊天就这样切换到语音,好友开始找她借钱,数额不大, 2000 块。她毫不犹豫地转过去了。紧接着好友第二次、第三次向她借钱,她开始察觉事情有些不对。

事情确实不对,刘倩没想到,那个声音、语气一如既往地熟悉,甚至能清晰记得他们多年前共同经历的「好友」是个诈骗犯。

骗子在获取了刘倩好友的声音素材之后,用 AI 合成的「好友」声音与之对话;熟悉的语气和共同的回忆则「归功于」AI 在网上搜集分析了刘倩微信、微博等个人信息。

大多数受骗者都与刘倩有着类似的经历。不过是司空见惯的网络诈骗手法,一旦被 AI 变声、换脸所营造出来的逼真假象所懵逼,受骗的几率极大地提高了。

骗子用 AI 将自己合成假王源,在直播平台上大肆行骗;公司员工被「上司」的一通电话骗走了 22 万欧元;学校工作人员则在收到一封看起来内容真诚可信的邮件之后,被「合作伙伴」骗走巨额项目合作款。

多名经手过 AI 诈骗案例的民警和律师告诉 CV 智识,随着技术的进步,网络诈骗的手段往往也花样不断、新招频出,一次又一次的突破人们的认知和想象。

「前些年行骗者利用恶意邮件、短信或者电话行骗的手段已经逐渐能够被社会大众识别和破解,但近年来兴起的基于 AI 技术的诈骗手段大家还没有形成普遍的警觉。」

AI 诈骗,多快好骗

你的声音正在你看不见的地方被 AI 加工,成为骗子用来诱骗你周围人在网上向「你」转账的得力工具。

2019 年,AI 诈骗事件进入人们视野的比例逐渐上升。从普通人到明星偶像,甚至是办事章程复杂、流程规范的商业公司、学校机构,无一不曾陷入骗子用人工智能布下的完美陷阱。

「朋友发过来一条语音,让我微信转账给他 2000 块钱,我一听是他的声音,就毫不犹豫转给他了。」更多的语音信息发过来,刘倩从来没有怀疑过,她本能地相信,这个正和她在微信上聊着天的人就是她的朋友。

然而让刘倩没想到的是,这条与朋友声音一模一样的语音,并不出自朋友之口,直到更多的人询问刘倩转账的事情,她才意识到,自己上了骗子的当。

但她还是有些想不明白,这样和朋友一模一样的声音,骗子是怎么做到的?「跟朋友的声音、语调、语气一模一样,真的一模一样,朋友听完都脊背发凉。」

更让刘倩觉得不可思议的是,「骗子连我们几年前微信聊天用到的词都能知道,也是神奇了。」一模一样的声音,加上熟悉的聊天方式,让刘倩更加确信了向她借钱的就是朋友本人。

「骗局其实很拙劣,但加上 AI 的手法,真是防不胜防。」刘倩向 CV 智识回想起这次被骗的经历,现在再也不敢说被骗的人没文化了,原来不是被骗的没文化,真的是骗子太高强。

语音诈骗揭开了 AI 诈骗的冰山一角。当人们还在感叹区区毛骗,何足挂齿的时候,有骗子已经把 AI 这门新技术运用得炉火纯青——算法筛选被骗群体、分析你的个人特点和喜好,机器人定时拨打骚扰电话,再加上换脸、变声等一系列操作,让人想不相信骗子是你都难。

CV 智识了解到,过去几个月内,类似操作手法的 AI 诈骗事件开始增多,有网友被「同事」骗走两万多,「骗子声音特别逼真,以公司副总名义骗得,转账后跑去领导办公室核实,结果得知被骗了。」有学生家长被骗,「儿子在读大学,我们(父母)街道要转账的电话,电话里说要转钱留个保研位,就一口气转了好几万。」

多位民警也向 CV 智识表示,之前从未遇到过 AI 诈骗案例,但今年以来这样的案例正在增加。「遇到过语音诈骗,但还没有遇到过换脸换头的情况,这种运用技术手段进行的诈骗,虽然目前来说还不普遍,但陆续出现一些了。」

在民警们看来,虽然目前 AI 诈骗案例较少,但因为其强伪装、高成功率,仍然十分值得警惕。

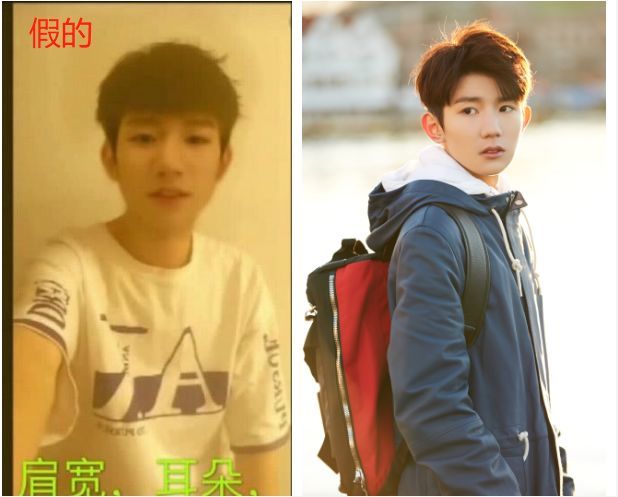

不止普通人,明星偶像乃至商业公司也曾屡屡陷入 AI 诈骗风波。有骗子用 AI 换脸成王源,然后直播骗钱,引得粉丝纷纷来刷礼物,而在骗术被粉丝识破后,该骗子竟变本加厉、扬言要报复:做一个「王源」在 KTV 抽烟喝酒的视频,然后卖给自媒体以制造负面新闻。

据《华尔街日报》报道,今年 3 月,一名诈骗犯利用 AI 语音模仿软件冒充公司大老板,成功地模仿了那位董事长夹杂德国口音的英语,让一家英国能源公司的总经理相信自己正在与德国母公司的老板通电话,并骗走了 22 万欧元。

美国南俄勒冈大学曾被诱骗向进行了 190 万美元的转账,他们认为自己的转账对象是负责建设学生娱乐中心的安德森建筑公司,实际上却转到了骗子的银行账户。

钓鱼邮件早已经不是什么新鲜的攻击手段了,但如果与人工智能相结合,使攻击者能够访问公司网络并说服员工授权转账,那带来的后果就会非常可怕。

换脸、变声,AI「过滤」——算法筛选受骗对象,搜集并且分析受骗者信息,则让受骗者放下了最后一道心理防线。正如刘倩所说,骗子和朋友近乎一样的说话方式令她感到诧异。

愈发频繁的 AI 诈骗事件引发了人们对人工智能被用于犯罪的担忧。

AI 诈骗为何能「瞒天过海」?

语音聊天、视频通话,一些看似老套低级的骗术,为什么一旦用上了 AI 的技术,就可以如此轻易地骗过人类?

现在的 AI 变脸、变声技术已经完全可以做到通过算法来生成人的全套语音,甚至连不同语气都可以做到惟妙惟肖,以假乱真。

因为机器人语音系统还可能存在卡顿、音色机械化、语气表现力不足、多轮对话「鬼打墙」等问题,但通过 AI 变声技术, 不仅说话的声音达到了真人水准,甚至还能模仿真人的情感和语调,自动说出全新的语句。

「用方言说话总能验证出来对方是不是骗子吧?」没有受过骗的网友发出侥幸的质疑。

科大讯飞已经推出了四川、广东等地口音的语音识别,同理,带有特殊口音或者纯方言的语音合成也是可以做到的。

AI 伪装成「老板」电话,讲出带有德国腔的英文,要求必须在一个小时之内给「匈牙利供应商」转账,成功骗走 22 万欧元,就是一个典型的案例。

而除了能够利用神经网络对原始音频进行建模和模仿之外,AI 还能够分析本人的社交网络,很快掌握个性化的说话方式、与周围人的关系、兴趣爱好等等,从而模仿你与身边的人自然地交流。

一模一样的声音,再加上一模一样的聊天方式,让人想不相信与你聊天的就是你熟悉的朋友都难,骗子就是这样成功骗取了刘倩等人的信任。

要生成这样的语言,仅仅需要被生成者的几段话。

骗子完全可以通过骚扰电话提取到大家的声音,然后通过机器学习或者深度学习软件进行合成,从而在语音层面欺骗我们。

那直接视频通话进行验证身份,还能被骗吗?

当然不是。

GitHub 上曾经有一个开源的项目代码仓库——Deepfake,以及前段时间异常火爆的换脸 App「ZAO」,这两个项目都能做到「移花接木」,将一个人的脸换到另一个人的身体上。

并且 ZAO 的出现让那些在编程方面没什么基础的人,只要搜索到了足够多的素材,就能完全「换脸」,人人都能够上手。

当变脸、变声这两者被组合起来,我们的声音和脸都可以被合成,于是就出现了直播平台上有人冒充王源绘声绘色地直播,却依然能骗过广大粉丝的一幕。

总得来说,目前常见的运用 AI 技术进行诈骗的方式一共有三种:

第一种,声音合成,也是目前发生频率最高的 AI 诈骗方式。骗子通过骚扰电话等方式,录音提取某人的声音,并对素材进行合成,用伪造的声音实施诈骗。

第二种:AI 换脸,视频通话的可信度明显高于语音和电话,利用 AI 换脸,骗子可以伪装成任何人。

第三种:通过 AI 技术筛选受骗人群,获取受骗者的聊天习惯、生活特性等。通过分析公众发布在网上的各类信息,骗子会根据所要实施的骗术对人群进行筛选,从而选出目标人群。例如实施情感诈骗时,可以筛选出经常发布感情信息的人群;实施金融诈骗时,可以筛选出经常搜集投资信息的人群。

大多数情况下,人们遇到的 AI 诈骗无非是这三种形式的排列组合,相对于传统的网络诈骗、电信诈骗,AI 诈骗的形势不存在什么新奇之处。

但就是电话、微信、视频这些老套低级的网络诈骗方式,一旦穿上了 AI 的外衣,一来用算法精准筛选特定受骗目标,分析人们的上网习惯,抓住人们的心理弱点;二来通过变声、变脸等手段达到以假乱真的效果,突破人们的信任防线,人们就很容易陷入骗子制造的「迷幻陷阱」。

当 AI 被用来诈骗,谁的责任?

距离第一批 AI 诈骗已经过去一段时间了,可随着越来越多简单易用的开源变脸变声软件出现,AI 诈骗的成本正变得越来越低,由此带来的新诈骗方式不但没有得到很好的治理,反而愈发频繁猖狂。

谷歌的 WaveNet、Lyrebird 语音合成软件,Adobe 的 Project VoCo,以及百度的 Deep Voice,科大讯飞、腾讯等等都提供语音合成的开源应用。

一位法院干警告诉 CV 智识,目前国内没有利用人工智能手段进行诈骗的已结案件,常见的是利用 AI 语言模仿软件冒充上级要求紧急转款,但在未来,随着 AI 诈骗的技术门槛不断降低,这种诈骗方式仍然十分值得警惕。

普通人应该如何应对 AI 诈骗呢?多名警察告诉 CV 智识,普通人可以通过多重验证,延迟转账,银行汇款,保护个人信息等方法保护个人权益,防止受骗。

「通过语音、电话、视频等多方式验证对方身份,询问一些双方才知道的信息;将到账时间设定为 2 小时到账或 24 小时到账,以预留处理时间。此外,可以选择向对方银行汇款,避免通过微信等社交工具转账。这样做,一方面便于核实对方信息,确认钱款去向;另一方面,对方能通过短信通知得知转账信息。」

同时,应谨慎使用各类 AI「换脸」、AI「变声」软件,加强个人信息保护意识,尽量少注册、不注册需要或者需求不高的网络账号,尽量少填写、不填写不必要的个人信息,以防个人信息泄露,尽量不给骗子可乘之机。

北京成竺律师事务所高级合伙人、律师王佳月告诉 CV 智识,无论多么高科技的诈骗,最根本的还是迎合民众「爱占便宜」、喜欢「不劳而获」、「爱面子」、「慌不择路」等心理和弱点,给犯罪分子预留了可作为的空间。

「首先还是从根源上杜绝贪婪的心理,并且时刻保持警醒、提高警惕、提高个人防范意识,知道自己才是个人资产安全的第一责任人。」

但面对威力如此高强的 AI 诈骗,仅仅是加强个人安全警示教育显然不够。科技公司开始为这些被他们所「创造」出来的技术承担责任,许多新的技术方法被应用在防范 AI 诈骗上。

比如安全公司赛门铁克,最近就提出了采用区块链技术和 IP 语音(VoIP)呼叫的方法,就是来辨别来电者的真实性,从而减少哪些模拟来自上级的诈骗电话。

再比如,卡迪夫大学和查尔斯三世大学的科学家通过 NLP 技术来判断书面谎言,通过一个名为 VeriPol 的工具来识别语句中的各种特征,判断出报告是否真实。对于一些伪装真人发出的诈骗邮件或书面文件,更强大的 AI 模型显然能起到很好的反制的作用。

当然,在不明确技术泛滥后果的前提下,合理地释放技术成果也成为一些科技企业的选择。比如 OpenAI 前段时间推出的性能更高的无监督语言模型 GPT-2,就没有按照行业惯例进行开源,只发布了简化版,不发布数据集、训练代码以及模型权重,目的就是避免 AI 被人恶意利用。

除了技术人员与骗子们斗智斗勇,产业界也开始从规则建设的层面,为滥用 AI 的行为设立了禁区。在美国安全中心发布的《人工智能与国家安全》报告中,明确将人工智能伪造技术列为威胁国家安全的重点技术。

中国也开始通过政策管理和技术限制等途径进行布局,来应对人工智能的潜在安全风险。

王佳月告诉 CV 智识,面对人工智能对法律、社会、道德、伦理等方面带来的新挑战,从 2017 年开始,国家立法就开始关注个人信息保护方面的立法,例如《网络安全法》从网络运营者收集、使用、保存个人信息上加以规范;针对「侵犯公民个人信息刑事案件」最高人民法院、最高人民检察院也出台了司法解释予以明确办案标准。

2019 年则出现了更多好消息,在十三届全国人大二次会议上,人工智能方面立法项目,如数字安全法、个人信息保护法等,已经被列入立法规划,同时被列入抓紧研究项目。《民法典人格权编》(审议稿)中也存在着加强人工智能技术法律规制等条文,对肖像权、声音保护等都将受到更加明确的规范,以应对人工智能的潜在安全风险。

硬币的反面

AI 出世,一骑绝尘。从技术人员、商业公司、社会管理者再到普罗大众,所有人都被人工智能的能力惊艳了,于是五花八门的换脸变声软件层出不穷。

随着技术的成熟,应用的门槛也在不断被降低,直到人工智能被做成一个个简单易上手的手机 App,普通人也可以轻松使用。

还有一个不容忽视的事实是,越是厉害的高科技,也越是具有杀伤力。人工智能技术使用不当,其副作用已经开始显现。

骗子向来是普通人里最热衷于尝试新方法、新手段的那一群人,当人工智能这把极具杀伤力的武器被骗子利用,普通人的生命财产安全也将受到更大威胁。

在经历了前几年的快速发展期后,今年,人工智能开始全面回归理性。在处理 AI 诈骗案件时,人们也越发意识到,仅靠警察办案与加强个人安全教育已经不能解决人工智能滥用所造成的一系列社会问题。

AI 诈骗正是人工智能这枚硬币反面的一个点,除了行骗,人工智能在被用来获取用户数据、个人信息,监控学生等方面同样引发了大量争议。

攻击者与防御者手中的武器都在升级迭代,而围绕 AI 生成的网络欺骗与安全问题有着太多意想不到的可能性,这场全新的斗法,正在从技术维度,走向常识、伦理、规则等更广阔的领地。

iNews新知科技 关注科技,自有新知

iNews新知科技 关注科技,自有新知